Superordinateur

|

|

Cet article ne cite pas suffisamment ses sources (octobre 2010). Si vous disposez d'ouvrages ou d'articles de référence ou si vous connaissez des sites web de qualité traitant du thème abordé ici, merci de compléter l'article en donnant les références utiles à sa vérifiabilité et en les liant à la section « Notes et références » (modifier l'article, comment ajouter mes sources ?).

|

Un superordinateur, ou supercalculateur, est un ordinateur conçu pour atteindre les plus hautes performances possibles avec les techniques connues lors de sa conception, en particulier en ce qui concerne la vitesse de calcul.

La science des superordinateurs est appelée « calcul haute performance » (en anglais High-Performance Computing, ou HPC).

Historique

Les premiers superordinateurs (ou supercalculateurs) apparaissent dans les années 1960. Conçus par Seymour Cray, pour le compte de la société Control Data Corporation (CDC), cette dernière est le premier constructeur mondial de superordinateurs à l'époque, jusque dans les années 1970. Par la suite, Cray Research, fondée par Seymour Cray après son départ de CDC, prend l’avantage sur ses autres concurrents, jusqu’aux alentours de l'année 1990. Dans les années 1980, à l’image de ce qui s’était produit sur le marché des micro-ordinateurs des années 1970, de nombreuses petites sociétés se lancèrent sur ce marché, mais la plupart disparaissent dans le « crash » du marché des superordinateurs, au milieu des années 1990.

Ce que désigne le terme superordinateur varie avec le temps, car les ordinateurs les plus puissants du monde à un moment donné tendent à être égalés, puis dépassés, par des machines d’utilisation courante plusieurs années après. Les premiers superordinateurs CDC étaient de simples ordinateurs mono-processeurs (mais possédant parfois jusqu’à dix processeurs périphériques pour les entrées-sorties) environ dix fois plus rapides que la concurrence. Dans les années 1970, la plupart des superordinateurs adoptent un processeur vectoriel, qui effectue le décodage d’une instruction une seule fois pour l’appliquer à toute une série d’opérandes.

C’est seulement vers la fin des années 1980 que la technique des systèmes massivement parallèles est adoptée, avec l’utilisation dans un même superordinateur de milliers de processeurs. De nos jours, certains de ces superordinateurs parallèles utilisent des microprocesseurs de type « RISC », conçus pour des ordinateurs de série, comme les PowerPC ou les PA-RISC. D’autres supercalculateurs utilisent des processeurs de moindre coût, de type « CISC », microprogrammés en RISC dans la puce électronique (AMD ou Intel) : le rendement en est un peu moins élevé, mais le canal d’accès à la mémoire — souvent un goulet d’étranglement — est bien moins sollicité.

Au XXIe siècle, les superordinateurs sont le plus souvent conçus comme des modèles uniques par des constructeurs informatiques « traditionnels » comme International Business Machines (IBM), Hewlett-Packard (HP), ou Bull, qu’ils aient derrière eux une longue tradition en la matière (IBM) ou qu’ils aient racheté dans les années 1990 des entreprises spécialisées, alors en difficulté, pour acquérir de l’expérience dans ce domaine.

Utilisation

Les superordinateurs sont utilisés pour toutes les tâches qui nécessitent une très forte puissance de calcul, comme les prévisions météorologiques, l’étude du climat (à ce sujet, voir les programmes financés par le G8-HORCs), la modélisation moléculaire (calcul des structures et des propriétés des composés chimiques, etc.), les simulations physiques (simulations aérodynamiques, calculs de résistance des matériaux, simulation d’explosion d’arme nucléaire, étude de la fusion nucléaire, etc.), la cryptanalyse, les simulations en finance et en assurance (Calcul stochastique), etc.

Les institutions de recherche civiles et militaires comptent parmi les plus gros utilisateurs de superordinateurs.

En France, on trouve ces machines dans les centres nationaux de calculs universitaires, tels que l’Institut du développement et des ressources en informatique scientifique (IDRIS), le Centre informatique national de l'enseignement supérieur (CINES), mais aussi au Commissariat à l'énergie atomique et aux énergies alternatives (CEA) ou dans certaines grandes entreprises, comme Total, EDF ou encore Météo-France[2].

Conception

Les superordinateurs tirent leur supériorité sur les ordinateurs conventionnels à la fois grâce à :

- leur architecture, en « pipeline » (exécution d’une instruction identique sur une longue série de données) ou parallèle (nombre très élevé de processeurs fonctionnant chacun sur une partie du calcul), qui leur permet d’exécuter plusieurs tâches simultanément ;

- de composants électroniques rapides.

Ils sont presque toujours conçus spécifiquement pour un certain type de tâches (le plus souvent des calculs numériques scientifiques : calcul matriciel ou vectoriel) et ne cherchent pas de performance particulière dans les autres domaines.

L’architecture mémorielle des supercalculateurs est étudiée pour fournir en continu les données à chaque processeur afin d’exploiter au maximum sa puissance de calcul. Les performances supérieures de la mémoire (meilleurs composants et meilleure architecture) expliquent pour une large part l’avantage des superordinateurs sur les ordinateurs classiques.

Leur système d’entrée/sortie est conçu pour fournir une large bande passante, la latence étant moins importante puisque ce type d’ordinateur n’est pas conçu pour traiter des transactions.

Comme pour tout système parallèle, la loi d’Amdahl s’applique, les concepteurs de superordinateurs consacrant une partie de leurs efforts à éliminer les parties non parallélisables du logiciel et à développer des améliorations matérielles pour supprimer les goulets d’étranglement restants.

Principaux obstacles techniques

D'une part, les superordinateurs ont souvent besoin de plusieurs mégawatts de puissance électrique. Cette alimentation doit aussi être de qualité. En conséquence, ils produisent une grande quantité de chaleur et doivent donc être refroidis pour fonctionner normalement. Le refroidissement de ces ordinateurs pose souvent un problème important de climatisation.

D'autre part, les données informatiques ne peuvent circuler plus vite que la vitesse de la lumière entre deux parties d'un ordinateur. Lorsque la taille d’un superordinateur dépasse plusieurs mètres, le temps de latence entre certains composants se compte en dizaines de nanosecondes. Les éléments sont donc disposés pour limiter la longueur des câbles qui relient les composants. Sur le Cray-1 ou le Cray-II, par exemple, ils étaient disposés en cercle.

De nos jours, ces ordinateurs sont capables de traiter et de communiquer de très importants volumes de données en très peu de temps. La conception doit assurer que ces données puissent être lues, transférées et stockées rapidement. Dans le cas contraire, la puissance de calcul des processeurs serait sous-exploitée.

Historique des records

| Date | Superordinateur | Constructeur | Type de processeurs ; fréquence | Nombre de processeurs | Puissance réelle (en FLOPS) | Emplacement |

|---|---|---|---|---|---|---|

| Z1 | Konrad Zuse | 1 FLOPS | chez Konrad Zuse, Allemagne | |||

| Z2 | Konrad Zuse | 5 FLOPS | chez Konrad Zuse, Allemagne | |||

| Z3 | Konrad Zuse | 5 33 Hz | 20 FLOPS | Deutsche Versuchsanstalt für Luftfahrt, Allemagne | ||

| Heath Robinson (en) | TRE | 200 FLOPS | Bletchley Park, Angleterre | |||

| Colossus Mark I | TRE | 5 kilo FLOPS | Bletchley Park, Angleterre | |||

| Colossus Mark II | TRE | 5 kFLOPS | Bletchley Park, Angleterre | |||

| ENIAC | 100 kHz | 50 kFLOPS | Aberdeen Proving Ground, États-Unis | |||

| 1956 | TX-0 | MIT Lincoln Laboratory | 3 600, 18 bits | 83 kFLOPS | Massachusetts Institute of Technology, États-Unis | |

| 1956 | TX-2 | MIT Lincoln Laboratory | 22 000, 36 bits 5 MHz | 83 kFLOPS | Massachusetts Institute of Technology, États-Unis | |

| 1958 | SAGE (en) | IBM | 400 kFLOPS | United States Air Force, États-Unis | ||

| UNIVAC LARC (en) | 500 kFLOPS | Lawrence Livermore National Laboratory et David Taylor Model Basin, États-Unis | ||||

| IBM 7030 | IBM | 1,2 Méga FLOPS | Los Alamos National Laboratory, États-Unis | |||

| 1964 | CDC 6600 | CDC | 3 MFLOPS | Lawrence Livermore National Laboratory, États-Unis | ||

| 1969 | CDC 7600 (en) | CDC | 36,4 MFLOPS | Lawrence Livermore National Laboratory, États-Unis | ||

| 1974 | Star-100 | CDC | 100 MFLOPS | Lawrence Livermore National Laboratory, États-Unis | ||

| 1975 | ILLIAC IV (en) | Burroughs | 150 MFLOPS | Ames Research Center (NASA), États-Unis | ||

| 1981 | Cyber-205 (en) | CDC | 400 MFLOPS | plusieurs endroits dans le monde | ||

| 1982 | Cray X-MP | Cray | Cray Vector 2*105 MHz | 2 | 400 MFLOPS | plusieurs endroits dans le monde [3] |

| 1984 | Cray X-MP/48 | Cray | Cray Vector 4*117 MHz | 4 | 800 MFLOPS | plusieurs endroits dans le monde [3] |

| 1984 | M-13 | 1 Giga FLOPS | Scientific Research Institute of Computer Complexes, URSS | |||

| 1985 | Cray-2 | Cray Vector 4*283 MHz | 4 | 1,7 GFLOPS | Lawrence Livermore National Laboratory, États-Unis | |

| 1989 | ETA10-G/8 (en) | 10,3 GFLOPS | Université de l’État de Floride, États-Unis | |||

| 1993 | CM-5 (en) | Thinking Machines Corporation (en) | SPARC | 1 024 | 59,7 GFLOPS | Los Alamos National Laboratory, États-Unis |

| 1993 | Numerical Wind Tunnel (en) | Fujitsu | Fujitsu VPP500 | 140 | 124,5 GFLOPS | National Aerospace Lab, Japon |

| 1994 | XP/S140 | Intel | Intel Paragon | 3 680 | 143,4 GFLOPS | Sandia National Labs, États-Unis |

| 1994 | Numerical Wind Tunnel (en) | Fujitsu | Fujitsu VPP500 | 140 | 170,4 GFLOPS | National Aerospace Lab, Japon |

| 1996 | SR2201 | Hitachi | Hitachi SR2201 | 1 024 | 220,4 GFLOPS | Université de Tokyo, Japon |

| 1996 | CP-PACS | Hitachi | Hitachi SR2xxx CP-PACS | 2 048 | 368,2 GFLOPS | Center for Computational Physics, Japon |

| 1997 | ASCI Red | Intel | Intel Paragon ASCI-Red | 7 264 | 1,07 TéraFLOPS | Sandia National Laboratories, États-Unis |

| 1997 | ASCI Red | Intel | Intel Paragon ASCI-Red | 9 152 | 1,34 TFLOPS | Sandia National Laboratories, États-Unis |

| 1999 | ASCI Red | Intel | Intel Paragon ASCI-Red | 9 472 | 2,12 TFLOPS | Sandia National Laboratories, États-Unis |

| 1999 | ASCI Red | Intel | Intel Paragon ASCI-Red | 9 632 | 2,38 TFLOPS | Sandia National Laboratories, États-Unis |

| 2000 | ASCI White (en) | IBM | IBM IBM POWER3 375 MHz | 8 192 | 4,94 TFLOPS | Lawrence Livermore National Laboratory, États-Unis |

| 2001 | ASCI White (en) | IBM | IBM IBM POWER3 375 MHz | 8 192 | 7,23 TFLOPS | Lawrence Livermore National Laboratory, États-Unis |

| 2002 | Earth Simulator | NEC | NEC SX6 1 000 MHz | 5 120 | 35,86 TFLOPS | Yokohama Institute for Earth Sciences, Japon |

| Blue Gene/L | IBM | PowerPC 440 (en) 700 MHz | 16 384 | 36,01 TFLOPS | Lawrence Livermore National Laboratory, États-Unis | |

| Columbia | SGI | Intel Itanium 2 1 500 MHz | 8 192 | 42,7 TFLOPS | Ames Research Center (NASA), États-Unis | |

| Columbia | SGI | Intel Itanium 2 1 500 MHz | 10 160 | 51,87 TFLOPS | Ames Research Center (NASA), États-Unis | |

| Blue Gene/L | IBM | PowerPC 440 (en) 700 MHz | 32 768 | 70,7 TFLOPS | Lawrence Livermore National Laboratory, États-Unis | |

| Blue Gene/L | IBM | PowerPC 440 (en) 700 MHz | 65 536 | 135,5 TFLOPS | Lawrence Livermore National Laboratory, États-Unis | |

| Blue Gene/L | IBM | PowerPC 440 (en) 700 MHz | 131 072 | 280,6 TFLOPS | Lawrence Livermore National Laboratory, États-Unis | |

| 2007 | Blue Gene/L | IBM | 478,2 TFLOPS | Lawrence Livermore National Laboratory, États-Unis | ||

| 2008 | Roadrunner | IBM | PowerXCell 8i 3 200 MHz | 129 600 | 1,042 Péta FLOPS | DoE-Los Alamos National Laboratory, Los Alamos, Nouveau-Mexique, États-Unis |

| 2009 | Jaguar (amélioré en Titan) | Cray | Processeurs six cœurs AMD | 224 162 | 1,759 PFLOPS | Laboratoire national d’Oak Ridge, États-Unis |

| 2010 | Tianhe-1A | NUDT (en) | Hybride : Intel Xeon + GPU Nvidia Tesla M2050 + FeiTeng-1000 | 14 366 + 7 166 | 2,566 PFLOPS | Tianjin, Chine |

| 2011 | K computer | Fujitsu | SPARC64 VIIIfx 2,0 GHz, Tofu interconnect | 68 544 | 10,510 PFLOPS[4] | Kobe, Japon |

| 2012 | Sequoia | IBM | BlueGene/Q, Power BQC 16C 1,60 GHz, Custom | 16,324 PFLOPS[5] | États-Unis | |

| 2012 | Titan (Jaguar amélioré) | Cray | Hybride : AMD Opteron + Nvidia Tesla K20 | 560 640 | 17,59 PFLOPS | Laboratoire national d’Oak Ridge, États-Unis |

| 2013 | Tianhe-2 | Intel | Hybride : Xeon E5-2692 + Xeon Phi | 32 000 + 48 000 | 33,86 PFLOPS | Université chinoise de technologie de défense[6] |

Historique des records en France

Avant 2006, le plus puissant des supercalculateurs français était le TERA, développé par Bull et basé sur des processeurs AlphaServer SC45 à 1 GHz, appartenant au Commissariat à l'énergie atomique et aux énergies alternatives (CEA). Il était classé 41e en , après avoir été quatrième à la mi-2002. En , le plus puissant supercalculateur français devient le TERA-10 de Bull, générant une puissance de calcul de 60 téraFlops.

En 2008, la barre du pétaFlops (1 000 téraFlops) est franchie par une machine américaine IBM, appelée Roadrunner, qui était aussi la plus efficace du point de vue de la consommation d’énergie[7].

En , le Grand Équipement National de Calcul Intensif (GENCI) commande à Bull une machine dotée de 2 136 processeurs Intel Xeon quadricœurs. La machine est installée au Centre de calcul recherche et technologie (CCRT) à Bruyères-le-Châtel (Essonne) début 2009, avec une puissance mesurée (test LINPACK) de 91 téraFlops[8].

En , la première machine française a pour nom Jade. De type « SGI Altix (en) » et basée au Centre informatique national de l'enseignement supérieur (CINES) à Montpellier, le supercalculateur se place au 28e rang mondial avec 128 téraFlops pour le test LINPACK. En , la configuration de la machine Jade est complétée et sa performance atteint 237 téraFlops. La machine passe au 18e rang mondial du TOP500[9]. C’est la troisième machine européenne et la première française. Elle est destinée à la recherche publique.

En , la première machine française est le TERA-100 de Bull. Installée au CEA à Bruyères-le-Châtel, pour les besoins de la simulation militaire nucléaire française, avec une performance de 1 050 téraFlops, la machine se place au sixième rang mondial et au premier rang européen[10]. Elle est constituée de 17 296 processeurs Intel Xeon 7500, dotés chacun de huit cœurs et connectés par un réseau de type InfiniBand.

En , Curie, un système conçu par Bull pour le GENCI, installé sur le site du Très Grand Centre de Calcul (TGCC) à Bruyères-le-Châtel, dispose d'une puissance de 1,359 pétaFlops[11] et devient le supercalculateur le plus puissant de France. Il est conçu pour délivrer 2 pétaFlops.

En , les systèmes Ada et Turing, construits par IBM, sont installés à l'Institut du développement et des ressources en informatique scientifique (IDRIS) d'Orsay. La somme de leur puissance dépasse le pétaFlops. Ces deux machines sont à la disposition des chercheurs. En mars 2013, le supercalculateur Pangea[12] détenu par Total est inauguré, devenant le système le plus puissant jamais installé en France. Sa puissance de calcul s'élève à 2,3 pétaFlops, équivalant à celle de 27 000 ordinateurs de bureau réunis.

Systèmes d'exploitation pour superordinateurs

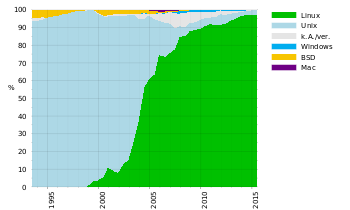

- Linux est le système d’exploitation équipant la très grande majorité des 500 supercalculateurs les plus puissants de la planète (92,4 % en juin 2012)[13],[14] ;

- Unix perd progressivement du terrain face à Linux, mais occupe encore une place de choix sur le marché des supercalculateurs (5 %) ;

- Windows n’est exécuté que par deux des 500 supercalculateurs les plus puissants de la planète, soit 0,4 %[13] ;

- BSD, quant à lui, ne dispose que d’une seule représentation dans le top 500, soit 0,2 % ;

- Enfin, les autres configurations (« Mixed », soit un ensemble de plusieurs types d’OS) représentent 4,6 %.

Supercalculateurs et jeu d'échecs

Notes et références

- ↑ « IBM Blue gene announcement », sur IBM.com, (consulté le 9 juin 2012).

- ↑ Classement Top 500 Juin 2013 http://top500.org/list/2013/06/.

- 1 2 (en) USDA National Nutrient Database for Standard Reference.

- ↑ TOP500 List - November 2011 (1-100) sur top500.org.

- ↑ TOP500 List - June 2012 (1-100) sur top500.org.

- ↑ Le plus puissant super-ordinateur au monde est chinois , Le Monde.fr avec l’AFP, 18 juin 2013.

- ↑ (en) Les plus puissants supercalculateurs du monde dépassent la barre du pétaflops sur top500.org.

- ↑ (en) Classement Top500 Juin 2009 - Titane sur top500.org.

- ↑ « Jade | TOP500 Supercomputing Sites », sur top500.org, (consulté le 11 juin 2010).

- ↑ (en) Tera-100 Classement Top500 novembre 2010 sur top500.org.

- ↑ TOP500 List - juin 2012 (1-100) sur top500.org.

- ↑ « Pangea : le supercalculateur de Total est le 14e plus puissant au monde », sur le site connaissancedesenergies.org - novembre 2013.

- 1 2 (en) Les supercalculateurs les plus puissants de la planète et leur système d’exploitation sur top500.org.

- ↑ Top 500 de juin 2012, sur linuxfr.org.

Annexes

Bibliographie

- Georges Karadimas (Snecma) « Les superordinateurs dans le secteur aérospatial français », dans Nouvelle revue Aéronautique et Astronautique, no 2, juin 1994, (ISSN 1247-5793).

Articles connexes

- Accélération matérielle

- Belle, Deep Blue et Hydra, des supercalculateurs spécialisés pour le jeu d'échecs

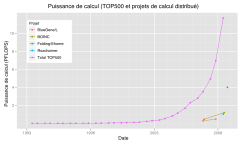

- BOINC - puissance de calcul distribuée sur des ordinateurs personnels : cf. le projet de l’université de Berkeley.

- EFF DES cracker

- GENCI

- Green 500

- Grille de calcul

- GPU

- Projet cerveau humain

- RIKEN MDGRAPE-3

- Seymour Cray

- TER@TEC - Pôle européen de compétence en simulation numérique haute performance - www.teratec.eu

- TOP500 : les 500 premiers superordinateurs au monde

- Musée de l'histoire de l'ordinateur

- Liste d'ordinateurs de fiction

Liens externes

- Site HPC du Commissariat à l'énergie atomique (CEA)

- Site du CINES

- Top500.org liste actuelle des 500 superordinateurs les plus performants

- Portail de l’informatique