Variance

Contexte des ??coles Wikip??dia

Cette s??lection de wikipedia a ??t?? choisi par des b??n??voles aidant les enfants SOS de Wikipedia pour cette s??lection Wikipedia pour les ??coles. Tous les enfants disponibles pour le parrainage de SOS Enfants des enfants sont pris en charge dans une maison de famille pr??s de la charit??. Lire la suite ...

Dans la th??orie des probabilit??s et des statistiques , la variance d'une variable al??atoire , distribution de probabilit?? , ou l'??chantillon est une mesure de dispersion statistique, la moyenne de la distance au carr?? des valeurs possibles de la valeur attendue (moyenne). Alors que la moyenne est une fa??on de d??crire l'emplacement d'une distribution, la variance est un moyen de capturer son ampleur ou le degr?? de se ??talant. Le unit?? de la variance est le carr?? de l'unit?? de la variable d'origine. La racine carr??e de la variance, appel??e ??cart-type , a les m??mes unit??s que la variable d'origine et peut ??tre plus facile ?? interpr??ter pour cette raison.

La variance d'une vraie variable al??atoire -??valu??es est sa deuxi??me moment central, et il arrive aussi d'??tre sa deuxi??me cumulant. Tout comme certaines distributions ne ont pas une moyenne, certains ne ont pas un ??cart aussi bien. La moyenne existe chaque fois la variance existe, mais pas vice versa.

D??finition

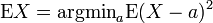

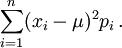

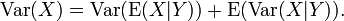

Si μ = E (X) est le valeur attendue (moyenne) de la variable al??atoire X, la variance est

Cette d??finition englobe les variables al??atoires qui sont discr??te , continue , ou aucun des deux. De tous les points sur lesquels les ??carts au carr?? aurait pu ??tre calcul??es, la moyenne produit la valeur minimale pour la somme moyenne des carr??s des ??carts.

De nombreuses distributions, tels que la Distribution de Cauchy, ne ont pas un ??cart parce que les int??grale diverge pertinents. En particulier, si la distribution ne est pas une valeur attendue, il n'a pas non plus une variance. L'inverse ne est pas vrai: il ya des distributions pour lesquelles la valeur attendue existe, mais la variance ne est pas.

Cas discret

Si la variable al??atoire est discr??te avec probabilit?? fonction de masse de p 1, ..., p n, ce qui ??quivaut ??

(Note: cette variation doit ??tre divis??e par la somme des poids dans le cas d'une discr??te variance pond??r??e.) Ce est, ce est la valeur attendue de la carr?? de l'??cart de X ?? partir de sa propre moyenne. En clair, il peut ??tre exprim?? comme ??La moyenne du carr?? de la distance de chaque point de la moyenne des donn??es". Ce est donc la d??viation quadratique moyenne. La variance de variable al??atoire X est g??n??ralement d??sign?? comme Var (X),  , Ou tout simplement σ 2.

, Ou tout simplement σ 2.

Propri??t??s

La variance est non-n??gatif, car les places sont positives ou nulles. La variance d'une variable al??atoire est ??gal ?? 0 si et seulement si la variable est d??g??n??r??e, ce est ?? dire qu'il prend une valeur constante avec une probabilit?? de 1, et la variance d'une variable dans un ensemble de donn??es est 0 si et seulement si toutes les entr??es ont le m??me valeur.

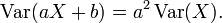

La variance est invariante par rapport aux changements dans un param??tre de position. Autrement dit, si une constante est ajout??e ?? l'ensemble des valeurs de la variable, la variance est inchang??. Si toutes les valeurs sont mises ?? l'??chelle par une constante, la variance est r??duite par le carr?? de cette constante. Ces deux propri??t??s peuvent ??tre exprim??es dans la formule suivante:

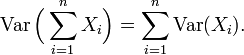

La variance d'une somme finie de variables al??atoires non corr??l??es est ??gale ?? la somme de leurs variances.

- Supposons que les observations peuvent ??tre divis??es en sous-groupes selon certains seconde variable. Ensuite, la variance de l'ensemble du groupe est ??gal ?? la moyenne des variances des sous-groupes ainsi que la variance de la moyenne des sous-groupes. Cette propri??t?? est connue sous le nom d??composition de la variance ou la droit de la variance totale et joue un r??le important dans la analyse de la variance. Par exemple, supposons qu'un groupe se compose d'un sous-groupe d'hommes et un aussi grand sous-groupe de femmes. Supposons que les hommes ont une longueur moyenne de corps 180 et que la variance de leurs longueurs est de 100. Supposons que les femmes ont une longueur moyenne de 160 et que la variance de leurs longueurs est de 50. Ensuite, la moyenne des variances est (100 + 50) / 2 = 75; la variance des moyens est la variance de 180, 160 qui est de 100. Ensuite, pour l'ensemble du groupe des hommes et femmes confondus, la variance des longueurs de corps sera 75 + 100 = 175. Notez que cette utilise N pour le d??nominateur au lieu de N - 1.

Dans un cas plus g??n??ral, si les sous-groupes ont des tailles in??gales, alors ils doivent ??tre pond??r??s proportionnellement ?? leur taille dans les calculs des moyennes et des variances. La formule est valable ??galement avec plus de deux groupes, et m??me si la variable de regroupement est continue.

Cette formule implique que la variance de l'ensemble du groupe ne peut pas ??tre plus petit que la moyenne des variances des sous-groupes. Notez, cependant, que la variance totale ne est pas n??cessairement plus grande que les variances des sous-groupes. Dans l'exemple ci-dessus, lorsque les sous-groupes sont analys??s s??par??ment, la variance est influenc??e seulement par les diff??rences homme-homme et les diff??rences femme-femme. Si les deux groupes sont combin??es, cependant, les diff??rences hommes-femmes entrent dans la variance aussi.

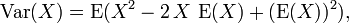

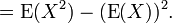

- De nombreuses formules de calcul pour la variance sont bas??es sur cette ??galit??:. L'??cart est ??gal ?? la moyenne des carr??s moins le carr?? de la moyenne Par exemple, si l'on consid??re les chiffres 1, 2, 3, 4 alors la moyenne des carr??s est (1 + 1 ?? 2 ?? 2 ?? 3 + 3 + 4 x 4) / 4 = 7,5. La moyenne est de 2,5, de sorte que le carr?? de la moyenne est de 6,25. Par cons??quent, la variance est 07/05 au 06/25 = 1,25, ce qui est bien le m??me r??sultat obtenu plus t??t avec les formules de d??finition. Beaucoup de calculatrices de poche utilisent un algorithme qui est bas?? sur la formule et qui leur permet de calculer la variance pendant que les donn??es sont entr??es, sans stocker toutes les valeurs en m??moire. L'algorithme consiste ?? ajuster seulement trois variables lorsqu'une nouvelle valeur de donn??es est entr??: Le nombre de donn??es saisies jusqu'?? pr??sent (n), la somme des valeurs pour l'instant (S), et la somme des valeurs au carr?? la mesure (SS) . Par exemple, si les donn??es sont 1, 2, 3, 4, puis apr??s avoir entr?? la premi??re valeur, l'algorithme faudrait n = 1, S = 1 et SS = 1. Apr??s avoir entr?? le deuxi??me valeur (2), il aurait n = 2, 3 et S = SS = 5. Lorsque toutes les donn??es sont saisies, il aurait n = 4, S = 10 et SS = 30. Ensuite, la moyenne est calcul??e comme M = S / n, et enfin la variance est calcul?? comme SS / n - M ?? M. Dans cet exemple, le r??sultat serait 30/4-2,5 ?? 2,5 = 7/5 ?? 6/25 = 1,25. Si l'estimation non biais??e de l'??chantillon doit ??tre calcul??, le r??sultat sera multipli??e par n / (n - 1), ce qui donne 1,667 dans cet exemple.

Propri??t??s, formelle

8.a. variance de la somme des variables non corr??l??es

L'une des raisons pour l'utilisation de la variance de pr??f??rence ?? d'autres mesures de la dispersion, ce est que la variance de la somme (ou la diff??rence) de variables al??atoires non corr??l??es est la somme de leurs ??carts:

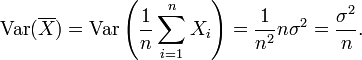

Cette d??claration est souvent faite avec la condition plus forte que les variables sont suffit ind??pendants, mais non corr??lation. Donc, si les variables ont la m??me variance σ 2, puis, depuis division par n est une transformation lin??aire, cette formule implique imm??diatement que la variance de leur moyenne est

Autrement dit, la variance de la moyenne diminue avec n. Ce fait est utilis?? dans la d??finition de la erreur type de la moyenne d'??chantillon, qui est utilis?? dans la th??or??me central limite.

8.b. variance de la somme des variables corr??l??es

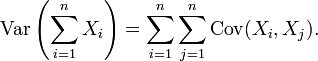

En g??n??ral, si les variables sont en corr??lation, la variance de leur somme est la somme de leur covariances:

Voici Cov est la covariance, qui est nul pour les variables al??atoires ind??pendantes (si elle existe). La formule indique que la variance de la somme est ??gale ?? la somme de tous les ??l??ments de la matrice de covariance des composantes. Cette formule est utilis??e dans la th??orie de Alpha de Cronbach dans th??orie classique des tests.

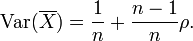

Donc, si les variables ont variance ??gale σ 2 et la corr??lation moyenne des variables distinctes est ρ, la variance de leur moyenne est

Ceci implique que la variance de la moyenne augmente avec la moyenne des corr??lations. En outre, si les variables ont variance unit??, par exemple si elles sont normalis??s, ce qui simplifie ensuite ??

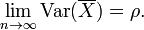

Cette formule est utilis??e dans la Spearman-Brown formule de pr??diction de la th??orie classique des tests. Cette converge vers ρ si n tend vers l'infini, ?? condition que la corr??lation moyenne reste constante ou converge aussi. Ainsi, pour la variance de la moyenne des variables avec des corr??lations normalis??es ??gales ou convergent corr??lation moyenne, nous avons

Par cons??quent, la variance de la moyenne d'un grand nombre de variables normalis??es est approximativement ??gale ?? leur corr??lation moyenne. Il est donc clair que la moyenne de l'??chantillon de variables corr??l??es ne convergent g??n??ralement ?? la moyenne de la population, m??me si le Loi des grands nombres indique que la moyenne de l'??chantillon vont converger pour les variables ind??pendantes.

8.c. variance d'une somme pond??r??e de variables

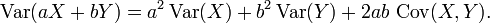

Propri??t??s 6 et 8, ainsi que cette propri??t?? de la page de covariance: Cov (aX, par) = ab Cov (X, Y) implique conjointement que

Ceci implique que dans une somme pond??r??e de variables, la variable avec la plus grande aura un poids de mani??re disproportionn??e grand poids de la variance du total. Par exemple, si X et Y ne sont pas corr??l??es et le poids de X est deux fois le poids de Y, alors le poids de la variance de X sera quatre fois le poids de la variance de Y.

9. La d??composition de variance

La formule g??n??rale pour la d??composition de la variance ou la droit de la variance totale est: Si X et Y sont deux variables al??atoires et la variance de X existe,

Ici, E (X | Y) est le esp??rance conditionnelle de X ??tant donn?? Y, et Var (X | Y) est la variance conditionnelle de X sachant Y. (Une explication plus intuitive est que, ??tant donn?? une valeur particuli??re de Y, alors X suit une distribution de moyenne E (X | Y) et la variance Var (X |. Y) La formule ci-dessus indique comment trouver Var (X) sur la base du distributions de ces deux quantit??s, lorsque Y est autoris?? ?? varier.) Cette formule est souvent appliqu??e en analyse de la variance, o?? la formule correspondante est

Il est ??galement utilis?? dans la r??gression lin??aire analyse, o?? la formule correspondante est

Cela peut aussi ??tre d??riv?? de l'additivit?? des ??carts (propri??t?? 8), depuis le (observ??) le score total est la somme du score pr??dit et le score d'erreur, o?? les deux derniers ne sont pas corr??l??s.

10. formule de calcul de la variance

Le formule de calcul de la variance suit d'une mani??re simple ?? partir de la lin??arit?? des valeurs attendues et la d??finition ci-dessus:

Ceci est souvent utilis??e pour calculer la variance dans la pratique, m??me si elle souffre de approximation num??rique erreur si les deux composantes de l'??quation sont similaires en amplitude.

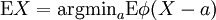

Propri??t?? caract??ristique

Le deuxi??me moment d'une variable al??atoire atteint la valeur minimum lorsqu'il est pris autour de la moyenne de la variable al??atoire, soit  . Cette propri??t?? pourrait ??tre invers??e, ce est ?? dire si la fonction

. Cette propri??t?? pourrait ??tre invers??e, ce est ?? dire si la fonction  satisfait

satisfait  il est alors n??cessaire de la forme

il est alors n??cessaire de la forme  . Ce est aussi vrai dans le cas multidimensionnel.

. Ce est aussi vrai dans le cas multidimensionnel.

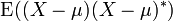

Approximation de la variance d'une fonction

Le Proc??d?? utilise delta du deuxi??me ordre d??veloppements de Taylor ?? approximation de la variance d'une fonction d'une ou plusieurs variables al??atoires. Par exemple, la variance approximative d'une fonction d'une variable est donn??e par

?? condition que f est d??rivable deux fois et que la moyenne et la variance de X sont finies.

G??n??ralisations

Si  est un vecteur ?? valeurs variable al??atoire, ?? valeurs dans

est un vecteur ?? valeurs variable al??atoire, ?? valeurs dans  Et consid??r?? comme un vecteur de colonne, puis la g??n??ralisation naturelle de la variance est

Et consid??r?? comme un vecteur de colonne, puis la g??n??ralisation naturelle de la variance est  O??

O??  et

et  est la transpos??e de

est la transpos??e de  , Et est donc un vecteur ligne. Cet ??cart est un matrice carr??e semi-d??finie positive, commun??ment d??nomm?? matrice de covariance.

, Et est donc un vecteur ligne. Cet ??cart est un matrice carr??e semi-d??finie positive, commun??ment d??nomm?? matrice de covariance.

Si  est un complexe variable al??atoire -??valu??es, ?? valeurs dans

est un complexe variable al??atoire -??valu??es, ?? valeurs dans  , Puis sa variance est

, Puis sa variance est  O??

O??  est le conjugu?? complexe de

est le conjugu?? complexe de  . Cet ??cart est ??galement une matrice carr??e semi-d??finie positive.

. Cet ??cart est ??galement une matrice carr??e semi-d??finie positive.

Histoire

Le terme de variance a ??t?? introduite par Ronald Fisher dans son document de 1918 La corr??lation entre les parents sur la supposition de mend??lienne H??ritage.

Moment d'inertie

La variance d'une distribution de probabilit?? est analogue ?? la moment d'inertie dans la m??canique classique d'une distribution correspondante de masse le long d'une ligne, par rapport ?? la rotation autour de son centre de masse. Ce est en raison de cette analogie que de telles choses que la variance sont appel??s moments de distributions de probabilit?? . (La matrice de covariance est analogue ?? la moment d'inertie tenseur pour les distributions multivari??es.)

![\ Operatorname {} Var (X) = \ operatorname {} E [(X - \ mu) ^ 2] \,.](../../images/82/8221.png)

![\ Operatorname {var} \ left [f (X) \ right] \ approx \ gauche (f '(\ operatorname {E} \ left [X \ right]) \ right) ^ 2 \ operatorname {var} \ left [X \ right]](../../images/82/8242.png)