Web profond

|

|

Cet article est une ébauche concernant Internet. Vous pouvez partager vos connaissances en l’améliorant (comment ?) selon les recommandations des projets correspondants.

|

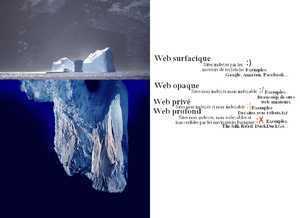

Le web profond ou web invisible ou encore web caché (en anglais deep web) est la partie de la Toile accessible en ligne, mais non indexée par des moteurs de recherche classiques généralistes ; certains moteurs, tels que BASE, prennent cependant en compte cette partie du réseau. La terminologie « web profond » est opposée à web surfacique.

Ne pas confondre

Le web profond n'est ni le web sombre, ni un réseau d'anonymisation — les services web auxquels on peut accéder via des outils tels Tor, Freenet, I2P, etc. —, ni le web opaque — indexable, mais non indexé — bien que, selon les conceptions, on peut considérer que ces deux derniers (voire les trois) en font partie.

Ressources profondes

Les robots d'indexation sont des programmes utilisés par les moteurs de recherche pour parcourir le web. Afin de découvrir de nouvelles pages, ces robots suivent les hyperliens. Les ressources profondes sont celles qui ne peuvent pas être atteintes facilement par les moteurs de recherche.

On peut classer les ressources du web profond dans une ou plusieurs des catégories suivantes :

- contenu dynamique ;

- contenu non lié ;

- contenu à accès limité ;

- contenu de script ;

- format non indexable.

Voir aussi la section Raisons de la non-indexation qui donne plus de précision.

Taille

Une étude de juillet 2001 réalisée par l'entreprise BrightPlanet[1] estime que le web profond pouvait contenir 500 fois plus de ressources que le web indexé par les moteurs de recherche. Ces ressources, en plus d'être volumineuses, sont souvent de très bonne qualité. Grâce au fait que la compression des fichiers est moins conséquente.

En 2008, le web dit « invisible » non référencé par les moteurs de recherche représente 70 à 75 % de l'ensemble, soit environ un trilliard de pages non indexées[2].

Web opaque

Une partie très importante du web est théoriquement indexable, mais non indexée de fait par les moteurs. Certains auteurs[3] parlent dans ce cas, pour le web non profond et non indexé, de « web opaque » (opaque web) ou de « web presque visible » (nearly visible web).

Pour résumer, si le web profond et le web opaque sont tout deux accessibles en ligne aux internautes, les deux ne sont pas indexés par les moteurs : mais le web opaque pourrait lui, être indexé.

Les algorithmes des moteurs étant semblables (par exemple, page rank), les zones indexées se recoupent en partie d'un moteur de recherche à l'autre. Les ressources matérielles des robots d'indexation ne sont pas, malgré des moyens matériels importants, à même de suivre tous les liens théoriquement visibles par eux, que le web (gigantesque) contient.

Une équipe de chercheurs allemands a étudié le comportement des robots d'indexation face à des sites contenant énormément de pages. Ils ont créé un site web composé de 2 147 483 647 pages (231 - 1). Ce site web étant un arbre binaire, il est très profond : il faut au minimum 31 clics pour arriver à certaines pages. Ils ont laissé ce site en ligne, sans le modifier, pendant une année. Les résultats montrent que le nombre de pages indexées pour ce site, dans le meilleur des cas, ne dépasse pas 0,0049 %.

Afin de résoudre ce problème de volumétrie de pages à indexer pour un site donné, le moteur Google a introduit en 2005 le protocole sitemap. Il permet, grâce à la mise à disposition du robot d'un fichier sitemap, de gagner en efficacité pour l'indexation. Ce fichier est mis à la racine du site par l'administrateur du site web.

Raisons de la non-indexation

- Les sites contiennent de plus en plus de pages dynamiques : les hyperliens de navigation sont générés à la demande et diffèrent d'une visite à l'autre.

- Certains sites (ou partie de sites) ne sont pas liées par d'autres pages et ne peuvent donc pas être découvertes par les robots d'indexation (le seul moyen de les faire indexer est dès lors de demander explicitement cette indexation au moteur de recherche, ce qui, souvent, n'est pas fait par ignorance de ce procédé). Ce contenu est connu comme des pages sans backlinks (ou inlinks).

- Il faut parfois remplir convenablement un formulaire de critères de recherche pour pouvoir accéder à une page précise. C'est le cas de sites exploitant des banques de données.

- Certains sites nécessitent une authentification (authentification requérant un identifiant login et un mot de passe) avant d'accéder au contenu réel : c'est le cas de certains sites payants et des sites avec des archives payantes (journaux en ligne, bases de données de météorologie, etc.).

- Les pages web peuvent dans leur conception rendre difficile leur indexation. Elles peuvent en particulier contenir des éléments HTML frameset au lieu des éléments classiques body. Les balises consistant en un fichier robot.txt inséré dans le code des pages permet de protéger leur copyright, limiter leur visite ou préserver des sites d’un accès trop fréquent. Or un robot n'est guère capable d'émettre des requêtes pertinentes ; sa visite d'indexation se réduit donc aux seules pages accessibles en suivant des URL statiques.

- L'utilisation du langage JavaScript (comme Ajax) incompris par les robots[réf. nécessaire], pour lier les pages entre elles constitue souvent un frein à leur indexation.

- Le web invisible est également constitué des ressources utilisant des formats de données incompréhensibles par les moteurs de recherche. Cela a été longtemps le cas du format PDF ou ceux de Microsoft Office (Excel, Word, Power Point…), le seul format reconnu initialement étant le langage natif du Web, l’html. Les grands moteurs de recherche (Google, Yahoo!, Bing…) sont capables d'indexer avec plus ou moins d'efficacité les documents utilisant ce format[4],[5]. Google reconnaît les pages au format flash[6] depuis le début de 2008.

- Les moteurs de recherche classiques n’indexent qu’entre 5 et 60 % du contenu des sites accueillant de grandes bases de données : Internet Movie Database, PubMed, le National Climatic Data Center qui met en ligne une base de données contenant 370 000 Gio, alors que celle de la NASA est de 220 000 Gio[7].

- Les moteurs indexent partiellement les pages volumineuses : Google et Yahoo! se contentent de 500 kilooctets[8].

Web privé

Certaines pages sont inaccessibles aux robots du fait de la volonté de l'administrateur du site web. Outre le fait d'utiliser dans ce but ce qui a déjà été décrit ci-dessus, il est possible, à l'aide d'un fichier (robots.txt) mis à la racine d'un site web, de tout bloquer ou juste une partie du site aux robots qui coopèrent, le site restant accessible aux internautes. Il est également possible d'utiliser l'élément meta robot dans le même but ainsi que pour empêcher de suivre des liens et interdire la mise en cache de pages données (indépendamment de l'autorisation d'indexation). Ces pages sont parfois rangées dans une catégorie connexe à celle du web profond : le web privé (private web).

Notes et références

- ↑ (en) Michael K. Bergman, « The Deep Web: Surfacing Hidden Value », The Journal of Electronic Publishing 2001, vol. 7, no 1.

- ↑ Francis Pisani et Dominique Piotet, Comment le web change le monde : l'alchimie des multitudes, éd. Pearson, 2008 (ISBN 978-2-7440-6261-2), p. 188.

- ↑ (en) Chris Sherman et Gary Price, The Invisible Web, septembre 2001

- ↑ (en) « Can A Search Engine Like Google.com Index My PDF Files? »

- ↑ (en) « Make your PDFs work well with Google (and other search engines) ».

- ↑ (en) « Webmaster Tools Help : Flash and other rich media files ».

- ↑ Jean-Paul Pinte, « Le Web invisible : l'antre du cybercrime », Pour la Science, no 70, janvier-mars 2011, p. 102

- ↑ Jean-Paul Pinte, « Le Web invisible : l'antre du cybercrime », Pour la Science, no 70, janvier-mars 2011, p. 103

Voir aussi

Articles connexes

- Gopher

- Darknet

Liens externes

- Christophe Asselin, Découvrir et exploiter le Web Invisible pour la veille stratégique, janvier 2006.

- Christophe Asselin, Web invisible, web caché, web profond

- Répertoire des bases de données invisibles sur Internet

- Mettre à jour le web invisible, Grand Dictionnaire terminologique

- Jean-Pierre Lardy, Le web invisible, 2003, Université Claude Bernard - URFIST.

- Le DeepWeb expliqué en détail sur GAMEDIA Presse

- Le web invisible[PDF], 2011, Université Nice Sophia Antipolis.

- Portail d’Internet